vtea

2

感谢您提供的功能建议!我们非常感激您抽出时间与我们分享您的想法。我们已经将您的建议记录在我们的反馈系统中,并将在适当的时候对其进行评估。我们会仔细考虑您的建议的可行性,并根据技术要求、产品方向以及用户需求来做出决策。我们将尽快向您提供反馈结果,并继续与您保持沟通。如果您有任何其他建议或者需要我们的帮助,请随时告诉我们。再次感谢您的支持!

odin

3

可以参考 oneapi 的实现

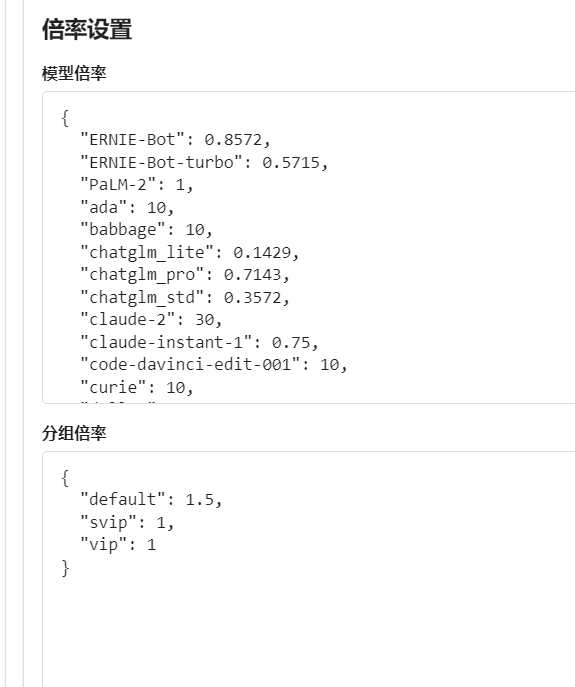

{

"ERNIE-Bot": 0.8572,

"ERNIE-Bot-turbo": 0.5715,

"PaLM-2": 1,

"ada": 10,

"babbage": 10,

"chatglm_lite": 0.1429,

"chatglm_pro": 0.7143,

"chatglm_std": 0.3572,

"claude-2": 30,

"claude-instant-1": 0.75,

"code-davinci-edit-001": 10,

"curie": 10,

"dall-e": 8,

"davinci": 10,

"gpt-3.5-turbo": 0.75,

"gpt-3.5-turbo-0301": 0.75,

"gpt-3.5-turbo-0613": 0.75,

"gpt-3.5-turbo-16k": 1.5,

"gpt-3.5-turbo-16k-0613": 1.5,

"gpt-4": 15,

"gpt-4-0314": 15,

"gpt-4-0613": 15,

"gpt-4-32k": 30,

"gpt-4-32k-0314": 30,

"gpt-4-32k-0613": 30,

"text-ada-001": 0.2,

"text-babbage-001": 0.25,

"text-curie-001": 1,

"text-davinci-002": 10,

"text-davinci-003": 10,

"text-davinci-edit-001": 10,

"text-embedding-ada-002": 0.05,

"text-moderation-latest": 0.1,

"text-moderation-stable": 0.1,

"text-search-ada-doc-001": 10,

"whisper-1": 10

}